种族主义与人工智能:“过去的偏见会导致未来的偏见”

2024年7月30日

联合国当代形式种族主义、种族歧视、仇外心理和相关不容忍行为特别报告员阿什维尼*表示:“生成式人工智能的最新发展和人工智能的蓬勃应用继续引发严肃的人权问题,包括对种族歧视的关切。”

在瑞士日内瓦人权理事会第五十六届会议期间,阿什维尼在就其最新报告开展的互动对话中指出,长期存在一种认为技术中立而又客观的有害观念。

她在报告中探讨了这种观念是如何使人工智能延续种族歧视的。

阿什维尼表示:“生成式人工智能正在改变世界,今后还有可能推动 日益剧烈的社会变革。人工智能应用在各个领域迅速普及,令我深感关切。这并不是因为人工智能不具备潜在的益处。事实上,人工智能为创新和包容提供了潜在机会。”

预测性警务就是种族偏见如何通过技术进步再现的一个显著例子。预测性警务工具根据位置和个人数据,对未来可能的犯罪者身份以及未来犯罪可能发生的地点进行评估。

阿什维尼表示:“预测性警务会加剧长久以来对种族和族裔社区过度执法的现象。由于执法官员历来将注意力集中在这些街区,附近的社区成员在警方记录中占比过高。这进而又会影响到算法所预测的未来犯罪地点,从而导致相关地区警力增加。”

根据她的调查结果,基于地点的预测性警务算法利用地点、事件和历史犯罪数据之间的联系来预测可能发生犯罪行为的时间和地点,警方据此制定巡逻计划。

“

当警方在被过度执法的街区记录到新的犯罪行为时,就会产生一个反馈回路,算法所生成的预测对这些街区的偏见越来越严重。简而言之,过去的偏见会导致未来的偏见。

“

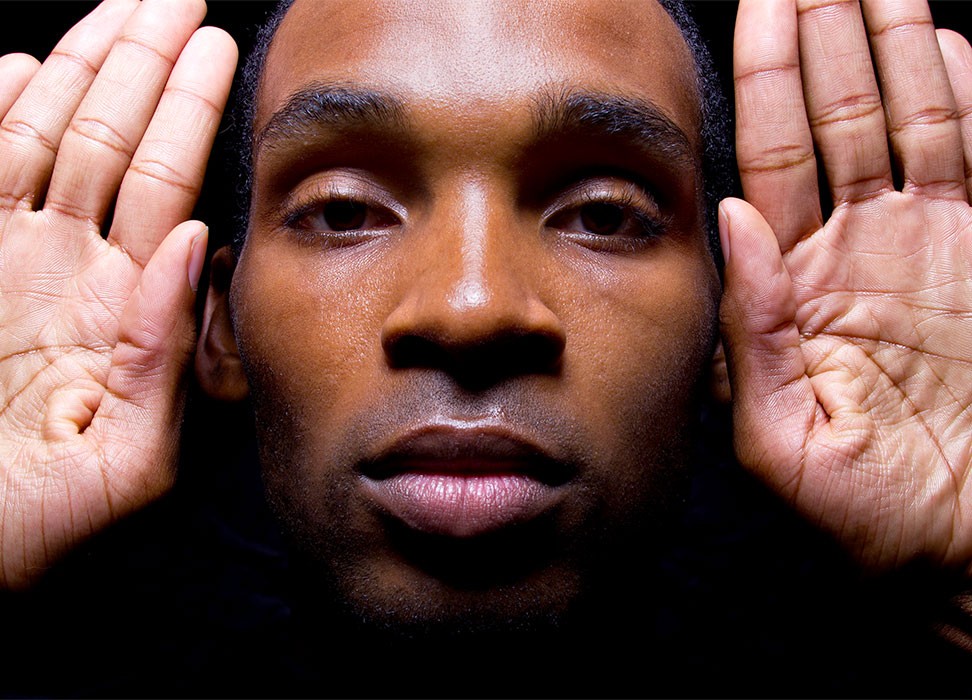

联合国当代形式种族主义、种族歧视、仇外心理和相关不容忍行为特别报告员阿什维尼·K.P.

阿什维尼指出,与基于地点的工具同理,由于已有的逮捕数据通常受到刑事司法系统中系统性种族主义的影响,这些算法对未来的预测可能出现偏差。

阿什维尼表示:“诸如社会经济背景、教育水平和地点等变量可以成为种族的替代变量,并固化了历史偏见。”

报告还简要分析了在国家、地区和国际层面管理和监管人工智能的努力。

阿什维尼表示:“人工智能技术应以国际人权法标准为基础。《消除一切形式种族歧视国际公约》对种族歧视予以最全面的禁止。”

人工智能还对其他权利构成风险,包括医疗保健领域的人工智能,一些用于设计健康风险评分的工具包含基于种族的校正因子。阿什维尼还发现,当人工智能应用于教育工具时,可能存在种族偏见。例如,在学业和职业成功算法中,由于算法设计和数据选择的原因,这些工具通常认为少数族裔在学业和职业生涯中取得成功的可能性较小,从而助长了排斥和歧视。

联合国人权事务高级专员福尔克尔·蒂尔克在他的愿景声明《人权:一条寻求解决方案的路径》中表示,生成式人工智能为进一步享受人权提供了前所未有的机会,然而其负面的社会影响已经在激增。

蒂尔克表示:“在人权风险特别高的领域,例如执法领域,唯一的选择是在引入足够的保障措施之前,暂停使用人工智能。”

对于阿什维尼而言,虽然人工智能确实具有真正的影响潜力,但它并不是所有社会问题的解决方案,必须实行有效管理以平衡好其益处和风险。

阿什维尼认为,监管人工智能也是确保达到这种平衡的一种方式。她建议各国以更大的紧迫感应对人工智能监管的挑战,警惕种族歧视的延续;在对系统性种族主义和人权法的理解基础上,制定人工智能监管框架;规定一项具有法律约束力的义务,在所有人工智能技术的开发和部署中开展全面的人权尽责评估,包括制定评估种族和族裔偏见的明确标准;并考虑禁止使用已被证明具有不可接受的人权风险的人工智能系统,包括那些助长种族歧视的系统。

蒂尔克指出:“将人权置于如何开发、使用和监管技术的核心位置,对于我们应对这些风险绝对至关重要。”

*阿什维尼·K.P.于2022年10月被人权理事会任命为特别报告员。她是一名关注社会排斥、种族、基于出身的歧视和交叉性的学者、活动家和研究员。她是斯坦福大学的访问学者。她曾在印度担任助理教授,也是“Zariya:妇女尊严与平等联盟”的联合创始人,该组织致力于加强团结并联结印度各边缘群体的妇女。她代表达利特妇女参加各类民间社会团体,帮助她们制定战略,确保边缘群体的妇女获得权能,使她们在行动主义和主流社会运动中发挥决策作用。